| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

- azure open ai service

- OpenAI

- runnableparallel

- azure ai

- csvloader

- langsmith

- Azure

- Runnable

- splitter

- rag

- 자연어처리

- azure open ai

- runnablepassthrough

- 문서/번역 서비스 사용

- GPT

- pdfloader

- teddynote

- Parallel

- lcel

- 자연어 처리

- 챗봇 만들기

- langchain

- azureai

- ai language

- runnablelambda

- chain생성

- RecursiveCharacterTextSplitter

- azure services

- webbaseloader

- Multimodal

- Today

- Total

Nathaniel

Azure AI Service 이론 음성 인식 서비스 24-08-08 본문

Azure AI 언어는 텍스트를 이해하고 분석하기 위한 NLP자연어처리 기능을 제공하는 클라우드 기반 서비스이다.

Language Sutdio, REST API 및 클라이언트 라이브러리를 사용하여 지능형 애플리케이션 빌드가 가능하다

Speech to Text

Azure AI 음성 서비스는 실시간 및 배치 음성 변환을 모두 지원하여 오디오 스트림을 텍스트로 변환

Text to Speech

음성합성이라고 부르는 텍스트 음성 변환 기능 도구 또는 장치에서 텍스트를 사람과 같은 합성 음성으로 변환

Azure에 이 서비스가 있는데 사용하려면 개인 정보를 입력해서 신청을 해야한다. 결국엔 내 정보를 팔아야 가능..

사유는 윤리적인 문제점으로 사용 불가하다고 한다.

Visme은 음성 언어에서 음소의 시각적 묘사이다. 단어를 말할 때 얼굴과 입의 위치를 정의한다.

링크 : https://www.visme.co/visme-home/?ref=k1wj1&SSAID=4346517

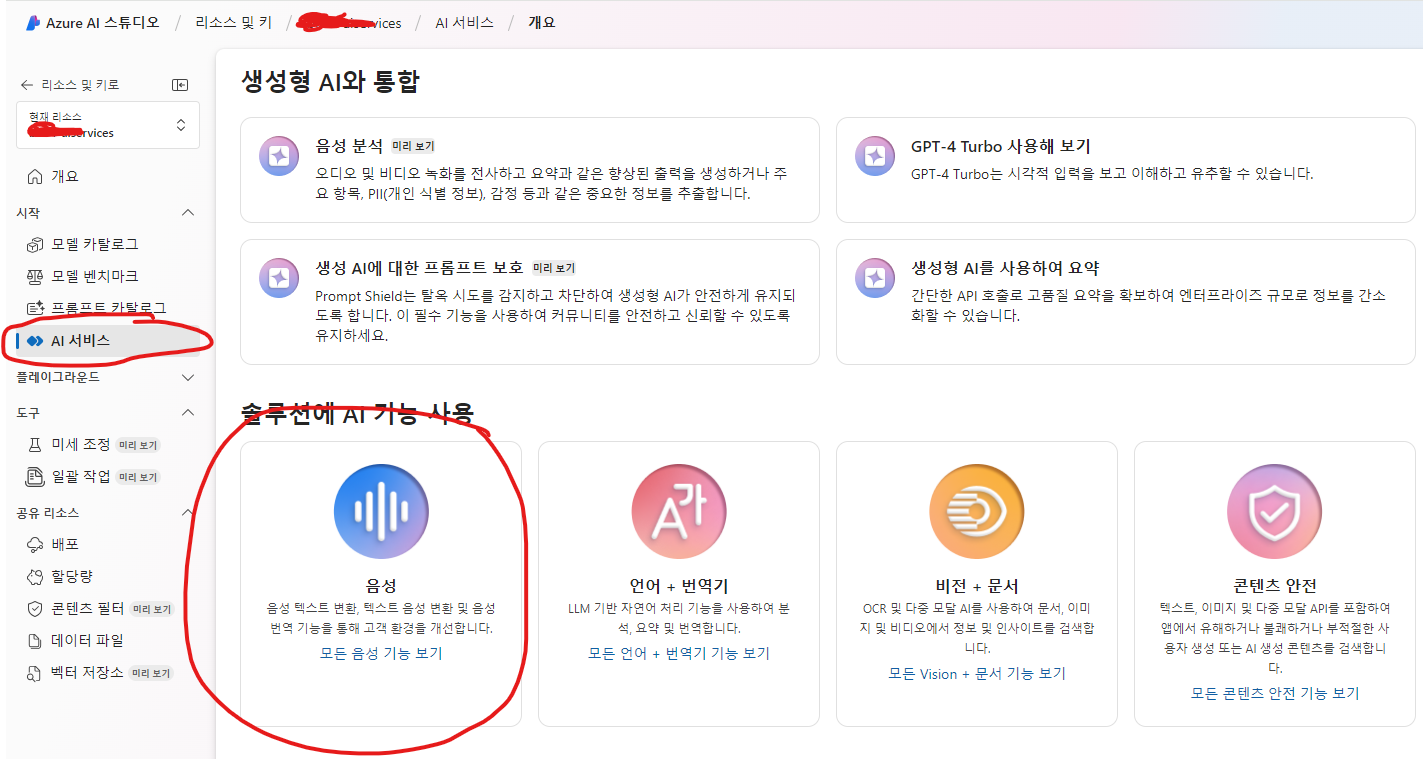

아래 사진은 Azure Services에서 Azure AI studio에 들어가서 음성으로 Text 인식하는 것을 test 하는 곳으로 가는 방법이다.

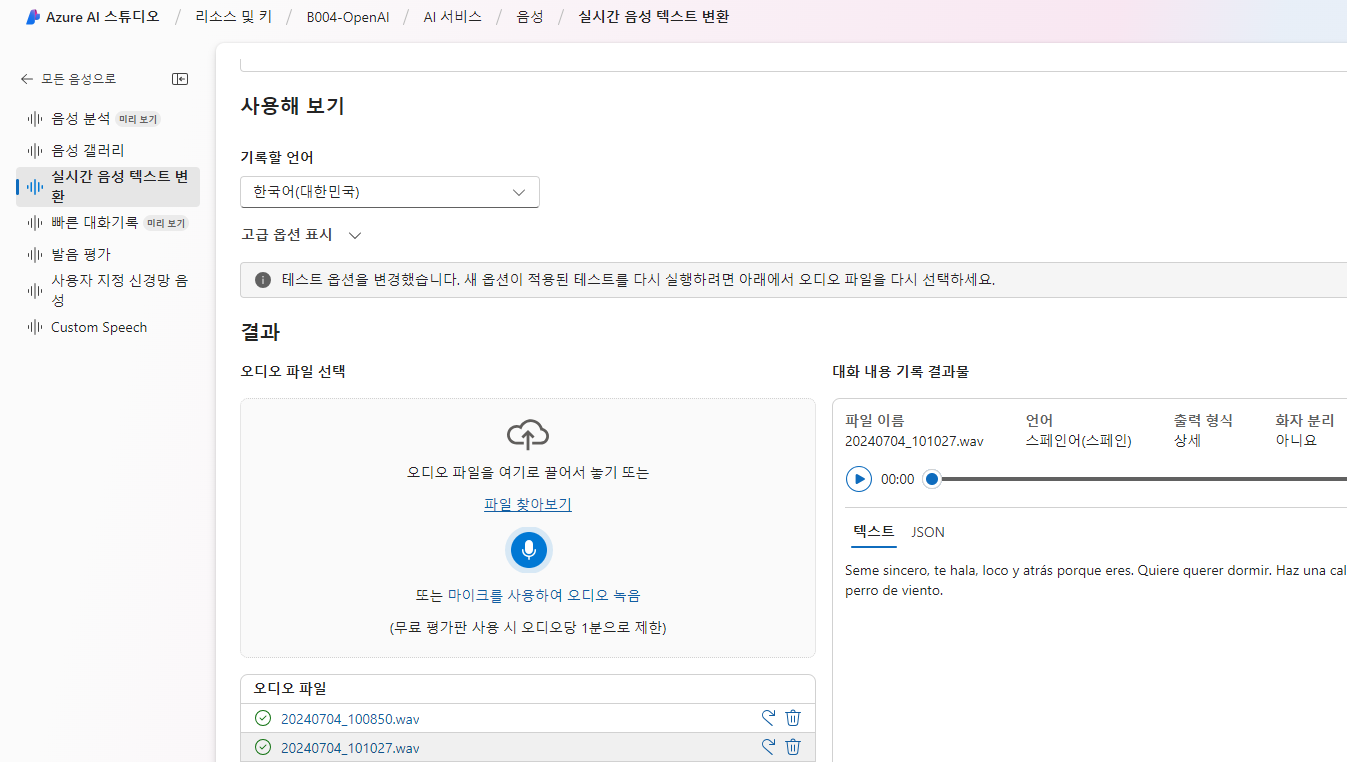

Azure AI 스튜디오에서 음성인식이 잘되나 한국어랑 스페인어 둘 다 해봤는데 인식을 굉장히 잘한다 ㅋㅋㅋㅋ

신기하다 옛날 같았으면 음성 인식이 진짜 잘 안됐는데 Text 변환 확실하다!

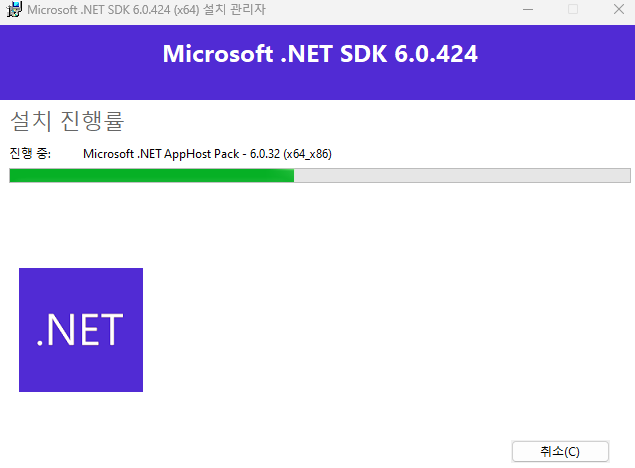

그리고 이번엔 Speech CLI를 설치해볼거다. 나는 Visual Studio를 설치 당시에 있어서 그런지 이미 설치가 되어있다.

윈도우 버전 CLI 설치 링크 : 지원되는 최신 Visual C++ 재배포 가능 패키지 다운로드 | Microsoft Learn

닷넷 버전별 나눠진 링크 : .NET 다운로드(Linux, macOS 및 Windows) (microsoft.com)

닷넷 설치 윈도우 64비트 링크 : .NET 6.0 SDK (v6.0.424) - Windows x64 Installer 다운로드 (microsoft.com)

오래 걸리지 않으니깐 그냥 적당히 기다리면 된다.

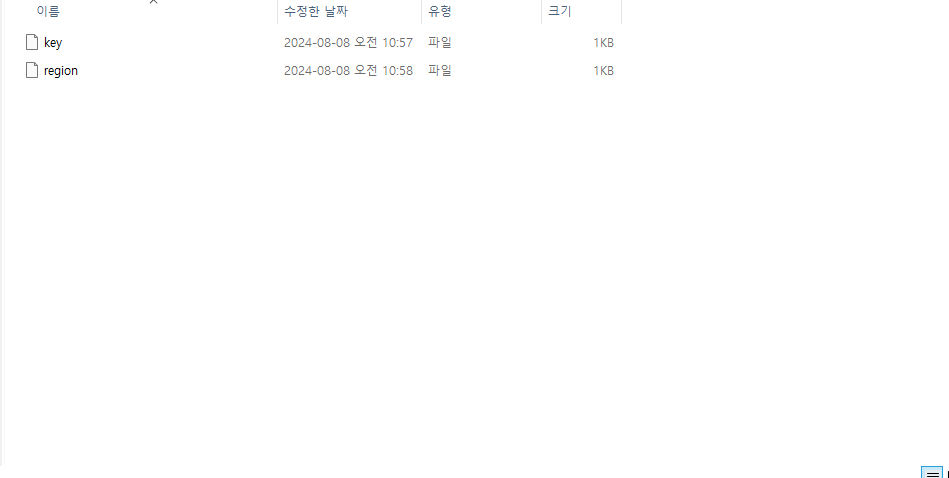

다 설치가 완료 됐으면, 아래처럼 폴더를 지정한 곳에 만들어준다!

원하는 위치에 파일 생성 후 작업

1. CMD 창을 켜서, cd Azure 디렉토리에

2. dotnet tool install --global Microsoft.CognitiveServices.Speech.CLI 입력

설치 준비를 기다린다. 설치가 완료되면 완료되었다는 문구가 뜬다.

그다음은 spx 입력하면 명령 문구를 볼 수 있다.

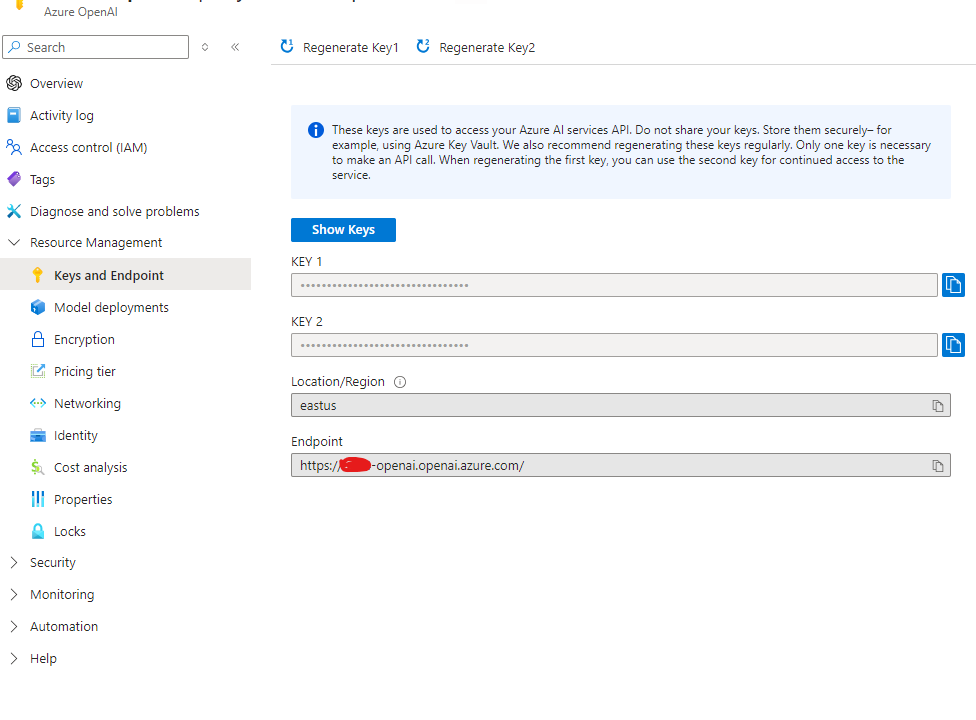

그다음 준비 과정은 AI Service 리소스에서 Key 값 확인 필요!!

아래 두 개의 값을 CMD 창에서 해야한다. Power Shell은 오류가 발생하기 때문에 금지

1. spx config @key --set "나의 KEY1 값"

2. spx config @region --set "나의 Region"

위 명령어 두 개를 입력하면, 생선한 폴더 내부에 파일이 2개가 만들어져 있는 것을 확인할 수 있다.

이제는 Post man을 들어가서 워크스페이스를 만든다.

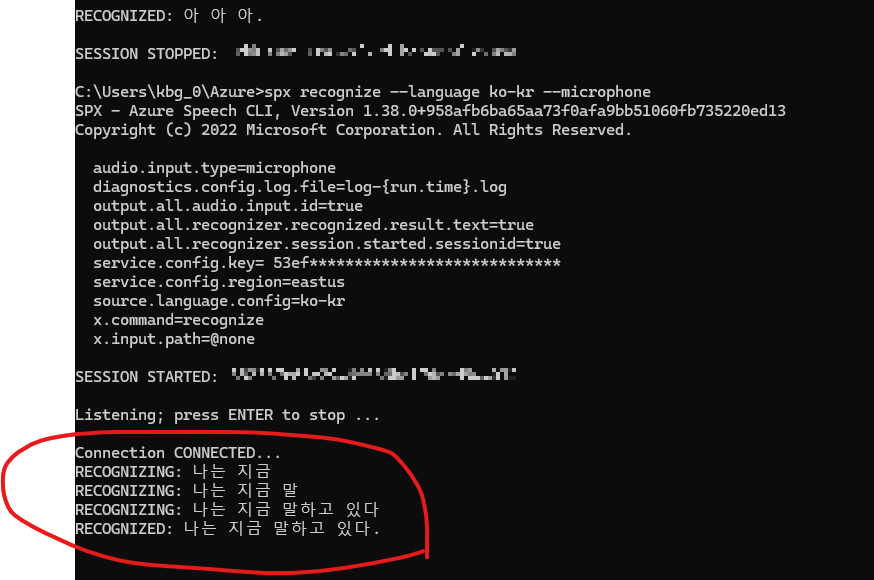

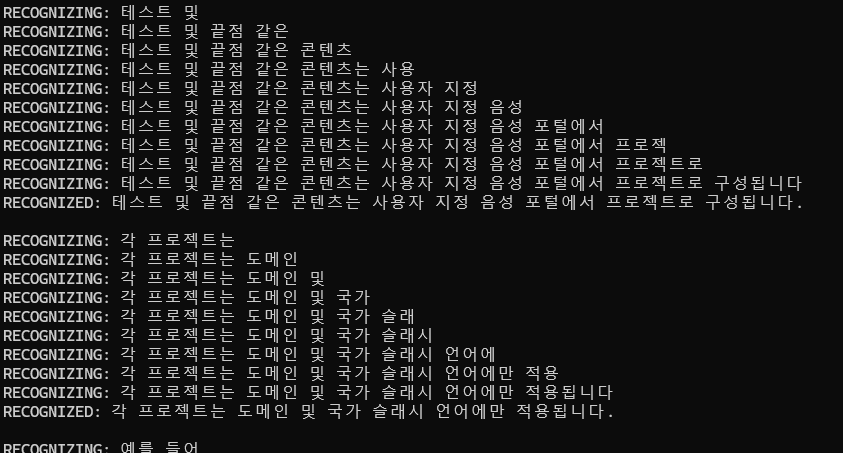

CMD 창에는 spx recognize --language ko-kr --microphone 입력해서 한글로 번역을 해줄 수 있도록 적용해준다.

ㅋㅋㅋㅋㅋ 와 내가 말하는 거를 CMD 창에서 잘 인식하고 Text가 나온다... ㅋㅋㅋㅋㅋㅋㅋㅋ

오디오 파일을 Azure 폴더 안에 넣어놓고 아래 명령을 입력하면, 전부 다 Text로 인식해서 폴더 안에 Output 파일을 생성해준다.

CMD 창에 spx recognize --language ko-KR --file c:\Users\fimtrus\azure\audio1.wav 입력

신기하긴하다 ㅋㅋㅋㅋㅋㅋ

Post man에서는 API 배치작업 테스트를 하는 것을 실습했다.

그냥 노코딩으로 웹에서 해보는 것이라서 개발자들은 자주 이용하고 편하다고 한다.

나는 그정도의 수준이 아니라, 그냥 그러려니 하는데 어떻게 보면 코딩을 안써서 굉장히 편리한 기능이 맞다고 생각한다.

포스트맨은 간단하게 나중에 포스팅을 해야겠다.

지금은 실습의 위주로 적어 넣어야지!!!

아래는 실습하는 과정 중의 하나인 Post man이다. 설명이 너무 빨라서 제대로 내용을 적지 못했다.

이제는 Post man에서 실습했던 내용을 적어보겠다. 우선 Azure AI 음성 인식 리소스를 만들고 Post mand를 사용하는 방식으로했다.

1. Token Endpoint : https://eastus.api.cognitive.microsoft.com/sts/v1.0/issueToken

2. Ocp-Apim-Subscription-Key:<API_KEY>

3. 페이지 한 개 더 만들어서 Endpoint. →: https://westus.tts.speech.microsoft.com/cognitiveservices/v1

4. Headers Header 4개이다.

# Header값

X-Microsoft-OutputFormat:riff-24khz-16bit-mono-pcm

Content-Type:application/ssml+xml

User-Agent:TestApplication

Authorization:Bearer <Your Token>

5. 마지막으로 Body Raw 값 넣고 파일 형식은 XML 형식으로 하면 이쁘게 볼 수 있다.

<speak version='1.0' xml:lang='ko-KR'><voice xml:lang='ko-KR' xml:gender='Female' name='ko-KR-JiMinNeural'>

안녕하세요? 저는 한국어를 사용하는 AI 입니다.

</voice></speak>

위 코드까지 다 적어 넣고, Send!! 누르면 맨~ 아래에 5초짜리 음성 파일이 생성됐다!!

생각보다 많이 적어 넣지는 못했다ㅜㅜ 너무 진도가 빨랐다....

오늘도 고생 많았따!!